انعکاس نور در چشم کلید شناسایی ویدئوهای دیپ فیک

محققان موفق شدند ابزار جدیدی بسازند که با بررسی انعکاس نور در چشم، جعلی بودن یا نبودن ویدئوها را تشخیص میدهد.

تاکنون، از دیپفیک برای اهداف شوم بسیاری استفاده شده است؛ از کمپینهای سیاسی که اطلاعات نادرست منتشر میکردند گرفته تا جعلکردن هویت افراد بسیار معروف در حوزههای مختلف. هر چقدر هم این فناوری پیشرفت میکند، تشخیص نسخههای جعلی از واقعی سخت و سختتر میشود.

بهگزارش thenextweb، اکنون ابزار جدیدی که از هوش مصنوعی استفاده میکند، راهی بسیار ساده برای تشخیص ویدئوهای دیپفیک را ارائه میدهد. در این روش، با بررسی نور منعکسشده در چشمها میتوان جعلی یا حقیقی بودن ویدئوها را تشخیص داد. این سیستم را دانشمندان کامپیوتری ساختهاند. در آزمایشهای انجامشده روی تصاویر پرتره، این ابزار ۹۴ درصد در تشخیص تصاویر دیپفیک موفق بوده است.

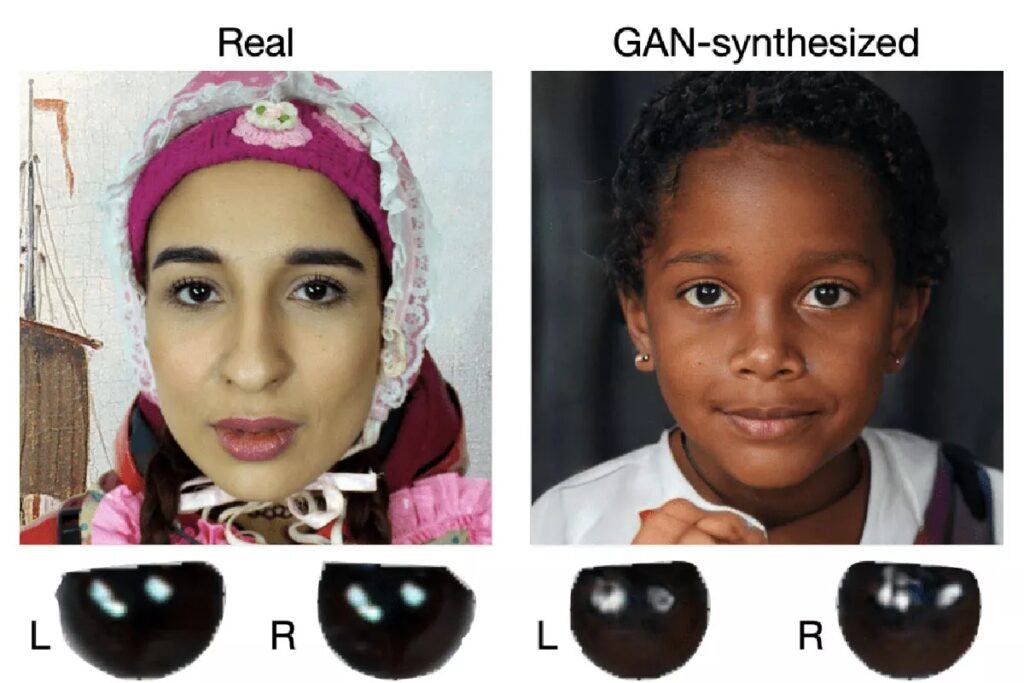

ابزار مذکور با تجزیهوتحلیل قرنیهها که سطحی آینهمانند دارند و پس از مواجه با نور الگوهای بازتابی خاصی ایجاد میکنند، میتواند ویدئوهای دیپفیک را شناسایی کند. در عکسی از چهرهی واقعی که با دوربین گرفته شده است، انعکاس روی دو چشم مشابه خواهد بود؛ زیرا آنها یک چیز را میبینند. بااینحال، تصاویر دیپفیک خلقشده با GANها معمولا نمیتوانند این مسئله را بهدرستی تقلید کنند. درعوض در ویدئوهای جعلی، اغلب ناهماهنگیهایی در بازتاب نور وجود دارد که با کمی دقت تشخیصپذیر هستند.

هوش مصنوعی با ترسیم چهره و تجزیهوتحلیل نور منعکسشده در هر کرهی چشم این اختلافات را جستوجو میکند. سیستم معیارسنجیای با آن ایجاد میشود که اگر ویدئو مدنظر نتواند امتیازهای لازم را بهدست آورد، بهعنوان دیپفیک شناخته میشود. درواقع، ویژگیهای تصویر بررسی میشود و درنهایت، امتیازبندی مشخص میکند که آیا ویدئو واقعی است یا خیر.

این سیستم در تشخیص دیپفیکهای موجود در This Person Does Not Exist، منبعی مملو از تصاویر ایجادشده با معماری StyleGAN2، بسیار موفق بوده است. باوجوداین، گفته میشود که محدودیتهای متعددی سر راه آن وجود دارد.

بارزترین نقص ابزار مذکور این است که به منبع نور منعکسشده در هر دو چشم متکی است. ناهماهنگیهای موجود در الگوها را میتوان با تنظیمات دستی پس از پردازش برطرف کرد و اگر یک چشم در تصویر مشاهدهکردنی نباشد، این روش کار نخواهد کرد. همچنین، نباید فراموش کرد که این سیستم فقط روی تصاویر پرتره کارآمد است و اگر سوژه به دوربین نگاه نکند، امکان تشخیص صحت ویدئو وجود ندارد.

محققان قصد دارند این مشکلات را بررسی و راهحلی برای آنها پیدا کنند تا ابزار جدیدشان بهبود یابد و قدرتمندتر شود. اکنون، سیستم مذکور توانایی تشخیص درست دیپفیکهای پیچیده را ندارد؛ اما میتواند برای ویدئوهای سادهتر کارآمد باشد. همین که اکنون ابزاری برای بررسی جعلی یا حقیقی بودن ویدئوها را در دست داریم، خود میتواند شروعکنندهی مسیر بسیار عالی باشد؛ زیرا دیپفیک در حال رفتن بهسمتی است که سودجویان میتوانند استفادههای زیادی از این فناوری ببرند.

منبع: زوم ایت